Crescem ferramentas maliciosas baseadas em IA no submundo do crime segundo Trend Micro.

O Setor de Pesquisas de Ameaças da Trend Micro, alerta para o aumento significativo de ferramentas baseadas em IA disponíveis na chamada dark web. Preocupada com esse avanço, a empresa acaba de lançar o Trend Micro Deepfake Inspector, nova tecnologia de detecção de deepfake que já está disponível para os consumidores, com download gratuito, e em breve será inserida na plataforma Trend Vision One™.

Os internautas podem aproveitar o Trend Micro Deepfake Inspector para se proteger contra golpistas que usam a tecnologia de troca de rosto durante chamadas de vídeo ao vivo. Além de utilizar uma variedade de métodos avançados para detectar conteúdo gerado por IA e adotar técnicas como análise de ruído de imagem e cores, a solução avalia elementos comportamentais do usuário, fornecendo uma abordagem muito mais assertiva contra a ação deepfake.

“Essas novas ferramentas de deepfake facilitam a ação dos cibercriminosos em golpes de engenharia social e tentativas de driblar a segurança, por isso estamos implementando novos recursos para detectar deepfakes e outras formas de fraudes que usam inteligência artificial, visando proteger nossos clientes e os consumidores em geral”, destaca Kevin Simzer, COO da Trend Micro.

Detectar e derrotar métodos baseados em IA é essencial para melhorar o gerenciamento de risco da superfície de ataque das empresas e reduzir o risco digital para os consumidores. Em pesquisa recente da Trend Micro, 71% dos entrevistados expressaram opinião negativa sobre deepfakes, acreditando que um de seus principais usos são as fraudes. Um deepfake não detectado pode gerar impactos financeiros, perda de postos de trabalho, desafios jurídicos, danos à reputação da empresa, roubo de identidade e prejuízos à saúde mental e física.

O abuso da IA Generativa pelo cibercrime

A comercialização de ferramentas de IA Generativa na deepweb está aumentando na mesma velocidade que cresce o uso da IA corporativa – e estão ficando cada dia mais baratas e acessíveis, permitindo que criminosos, independentemente do nível de habilidade, lancem ataques em larga escala com maior facilidade, enganando vítimas para fins de extorsão, roubo de identidade, fraude ou desinformação.

Segundo os pesquisadores, apenas algumas semanas após a divulgação do relatório sobre IA Generativa, já nota-se o surgimento de ferramentas mais sofisticadas de criação de deepfake. Os atores de ameaças estão proliferando ofertas de Modelos de Linguagem de Grande Escala (do inglês, Large Language Models ou LLMs), que usam algoritmo de aprendizado profundo e outras tecnologias de forma criminosa para aumentar o volume e a extensão de seu alcance.

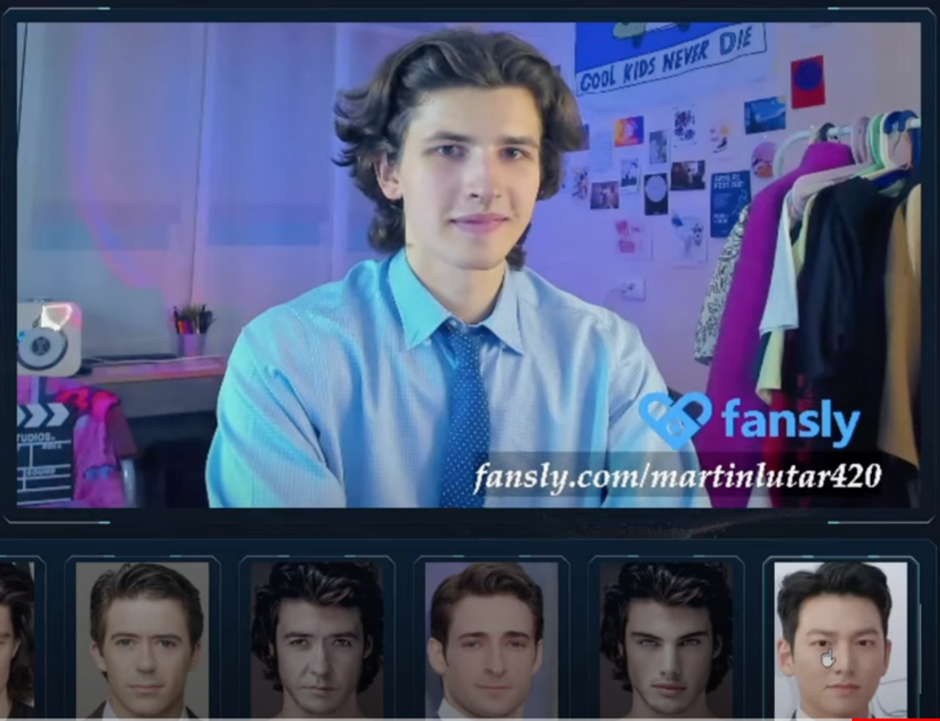

Capturas de tela do vídeo de demonstração do Swapface mostrando como o software funciona

Aplicativos chamados Deepfake AI, SwapFace e AvatarAI VideoCallSpoofer também foram disponibilizados. Se acreditarmos em seus anúncios, esses aplicativos poderiam substituir um rosto em um vídeo por um rosto totalmente diferente tirado de apenas uma ou algumas fotos, embora existam algumas diferenças importantes na forma como cada oferta funciona. Enquanto o Deepfake AI suporta vídeos gravados, o SwapFace, por exemplo, é implementado como um filtro de vídeo ao vivo, oferecendo até suporte para ferramentas populares de streaming de vídeo, como o Open Broadcast Software (OBS).

Esses bots são treinados especificamente com dados maliciosos, o que inclui código-fonte malicioso, métodos, técnicas e outras estratégias criminosas. “A necessidade de tais recursos decorre do fato de que os LLMs comerciais são programados para se recusar a obedecer a uma solicitação se esta for considerada maliciosa. Além disso, os atacantes geralmente têm medo de acessar diretamente serviços como o ChatGPT por medo de serem rastreados e expostos”, explica Flávio Silva, especialista em segurança cibernética da Trend Micro.

Flávio ressalta, ainda, que os front-ends de Jailbreak-as-a-service podem, supostamente, contornar essa censura, já que envolvem as perguntas maliciosas do usuário em um prompt especial, projetado para enganar um LLM comercial e persuadi-lo a dar uma resposta não filtrada.

A demanda por LLMs criminais está crescendo lentamente, mas de forma constante. Antigos LLMs criminosos, como WormGPT e DarkBERT, relatados como descontinuados no ano passado, estão de volta à cena. O que vale destacar nas versões recentes de DarkBERT e WormGPT é que ambos são oferecidos como aplicativos com a opção de “kit Siri”. Presume-se que seja uma opção habilitada por voz, semelhante aos recém-lançados assistentes de IA Humane e Rabbit R1. Isso coincide, também, com o anúncio do recurso pela Apple, na próxima atualização do iPhone.

Clique AQUI para ler mais detalhes do estudo “Surging Hype – An Update on the Rising Abuse of GenAI”.

Veja também:

- Precisamos falar sobre a tecnologia obsoleta em cibersegurança

- Pedido de resgate de dados atinge grandes corporações

- I.A. e os desafios dos Sistemas Liveness

- Segundo país mais visado por Cibercriminosos

- Líderes de TI afirmam que a gravidade dos ataques aumentaram

- O que o jurídicos precisam saber sobre ataques de ransomware

- Data Threat Report 2024: Cenário de Segurança de Dados

- Espiões, e não simples criminosos, por trás do zero-day

- Clubes viraram uma mina de petróleo para criminosos

- VPNs: para que servem? São legais no Brasil?

- Microsoft é a marca mais imitada em ataques de phishing

- Infoblox revela: Sindicato de crime cibernético chinês de trilhões de dólares

9 Trackbacks / Pingbacks